Steuerbescheide, Extraktion von Entitäten und Klassifizierung von Dokumenten mit Hilfe von Document AI

Einführung

Unser Team begann mit der Analyse der verschiedenen Bekanntmachungstypen und der Frage, welche relevanten Informationen aus den verschiedenen Bekanntmachungen extrahiert werden konnten.

Über UKG

Ultimate Kronos Group (UKG) ist ein amerikanisches multinationales Technologieunternehmen mit zwei Hauptsitzen in Lowell, Massachusetts, und Weston, Florida. Sie erbringt Dienstleistungen im Bereich Personalmanagement und Personalverwaltung. Als führender globaler Anbieter von HCM-, Lohn- und Gehaltsabrechnungs-, HR-Service- und Workforce-Management-Lösungen unterstützt UKG mit seinen preisgekrönten Pro-, Dimensions- und Ready-Lösungen Zehntausende von Unternehmen in allen Regionen und Branchen dabei, bessere Geschäftsergebnisse zu erzielen, die HR-Effizienz zu verbessern, den Lohnabrechnungsprozess zu rationalisieren und die Arbeit zu einem besseren und vernetzten Erlebnis für alle zu machen.

Die Herausforderung

Die wichtigsten Herausforderungen betrafen die zur Verfügung gestellten Daten. Die Daten der Steuerbescheide wurden in Form von PDF-Dateien bereitgestellt, die Probleme wie gedrehte Seiten, schlecht gescannte und/oder falsch ausgerichtete Seiten und leere Seiten auf jeder beliebigen Seite des PDF-Dokuments aufwiesen.

Eine weitere Herausforderung waren die Arten von Steuerbescheiden und deren Unterscheidung. Da es sich um eine große Anzahl von 200 bis 400 verschiedenen Arten von Bekanntmachungen handelte, war die Klassifizierung dieser Dokumente eine Herausforderung, da der Text/Kontext in den Dokumenten meist ähnlich war und es schwierig war, die Begriffe zu finden, die die Dokumente genau voneinander unterscheiden. Dazu mussten wir verschiedene Ansätze wie Jaccard Similarity, Naive Bayes usw. implementieren.

Für die Extraktion von Informationen oder Entitäten aus Dokumenten wurden die Dienste der Google Cloud Platform und Document AI verwendet. Der Document AI Forms Parser wurde verwendet, um unstrukturierte Daten zu verarbeiten und in ein strukturiertes Format zu konvertieren. Obwohl die erforderlichen Daten mit hoher Genauigkeit extrahiert wurden, hat der Parser einige wichtige Entitäten mit geringer Sicherheit extrahiert. Beim Speichern dieser extrahierten Daten wurde auch der Müllwert mit extrahiert. Wir mussten sie sorgfältig analysieren und die Verwendung von Müllwerten vermeiden.

„Technologie ist ein großer Gleichmacher, der es unseren Kunden ermöglicht, mit den größten Banken der Welt zu konkurrieren. Einer der wichtigsten technologischen Vorteile der Knoldus-Lösung ist die Möglichkeit der gemeinsamen Nutzung unseres Produktportfolios. Die wichtigen Ereignisse, die während der gesamten finanziellen Reise eines Endbenutzers auftreten, von der Eröffnung eines Kontos über die Aufnahme eines Kredits für ein Eigenheim oder ein kleines Unternehmen bis hin zum Sparen für das College oder den Ruhestand“, so Vice President, Hosting Architecture.

Die Lösung

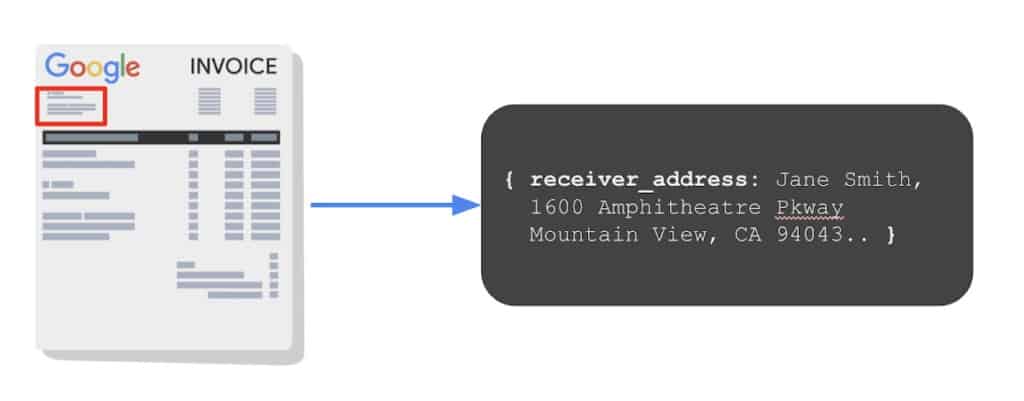

Unser Team analysierte zunächst die verschiedenen Arten von Bekanntmachungen und untersuchte, welche relevanten Informationen aus den verschiedenen Bekanntmachungen extrahiert werden konnten. Die erste Aufgabe bestand darin, den Document AI-Dienst zu nutzen, der die Daten mithilfe von Form Parser aus den Dokumenten extrahiert. Der Doc AI-Formularparser analysiert die Daten in Form von Schlüssel-Wert-Paaren. Diese extrahierten Daten aus allen Dokumenten wurden in der BigQuery-Tabelle gespeichert, um sie in späteren Phasen zu verwenden. Hier sehen Sie ein Beispiel dafür, wie der Document AI Form Parser Daten aus Dokumenten extrahiert.

Mit diesem Dienst/Prozessor war unser Team jedoch in der Lage, Daten zu extrahieren, die nur aus Schlüssel-Wert-Paaren bestanden. Für einige Daten wie Daten, Firmenname, Identifikationsnummer usw. gab es keinen Schlüssel, während einige wenige Entitäten im Inhalt der Absätze vorhanden waren, die extrahiert werden mussten. Google Cloud Data Loss Prevention (DLP) hat sich als eine sehr gute Lösung erwiesen. Data Loss Prevention (DLP) verwendet integrierte Infotyp-Detektoren, um Informationen aus Dokumenten zu extrahieren. Es gibt fast 150 verschiedene Informationstypen. Infotypen sind eine Art von sensiblen PII-Daten wie E-Mail-Adresse, Ausweisnummer, Kreditkartennummer, Geburtsdatum usw. Unser Team verwendete den integrierten Infotyp und erstellte außerdem einen benutzerdefinierten Infotyp für die Extraktion von Entitäten. Mit beiden Diensten, d. h. Google Document AI und Data Loss Prevention (DLP), war unser Team in der Lage, alle benötigten Daten zu extrahieren. Die Genauigkeit der Daten- und/oder Entitätsextraktion lag zwischen 85 % und 95 %.

Im nächsten Schritt haben wir diese extrahierten Daten verwendet, um sie manuell den erwarteten Datenfeldern zuzuordnen, die für jede Bekanntmachungsart benötigt wurden. Dies geschah manuell, um die zugehörigen Etiketten zu analysieren, die eine bestimmte Entität in dem Bekanntmachungsdokument darstellen. Ein Beispiel: Das erwartete Feld „NAME“ kann in verschiedenen Dokumenten unterschiedliche Bezeichnungen haben, z. B. [Name, Name des Steuerzahlers usw.] Diese manuell zugeordneten Daten wurden verwendet, um eine automatisierte Pipeline zu erstellen, die die genaue Bezeichnung der Entität und ihren Wert dem erwarteten Feld zuordnet.

Danach wurde die Dokumentenklassifizierung von Steuerbescheiden implementiert, bei der wir zunächst den Jaccard Similarity MinHash-Ansatz für die Klassifizierung verwendeten. MinHash ist eine LSH-Familie für die Jaccard-Distanz, bei der die Eingabemerkmale Mengen von natürlichen Zahlen sind. Der Jaccard-Abstand zwischen zwei Mengen wird durch die Kardinalität ihrer Schnittmenge und ihrer Vereinigung bestimmt. MinHash wendet eine zufällige Hash-Funktion auf jedes Element der Menge an und ermittelt das Minimum aller gehashten Werte. Wir haben jedoch festgestellt, dass die mit diesem Ansatz erzielte Genauigkeit recht gering war und die Ergebnisse nicht zufriedenstellend waren.

Der nächste Ansatz, der für die Klassifizierung verwendet wurde, war die Implementierung einer Multi-Klassen-Klassifizierung unter Verwendung von Naive Bayes Classifier und Hashing Trick, um OOV-Terme zu behandeln. Die Verwendung eines Hashing-Tricks hilft, das Problem des Speicherverbrauchs eines großen Vokabulars zu lösen, und entschärft auch das Problem der Umgehung der Filter. Mit diesem Ansatz stieg die Genauigkeit auf 75-85 %, und das Modell konnte die Steuerbescheide genauer klassifizieren.

Das Ergebnis

- Automatisierung der Extraktion von erwarteten Entitäten aus Steuerbescheiden.

- Automatisierung der Klassifizierung von Steuerbescheiden.

- Verringerung der manuellen Arbeiten und der Anzahl der manuell verursachten Fehler.

- Kann neue Bekanntmachungstypen effizient hinzufügen und ihre extrahierten Entitätsergebnisse speichern.

Weitere Fallstudien lesen

Vom Überwinden von Widrigkeiten zum Reiten der Welle der digitalen Transformation im Bildungssektor

Erfahren Sie, wie NashTech dem Trinity College London hilft, die Welle der digitalen Transformation im Bildungssektor zu reiten

Migration und Modernisierung der virtuellen Lernumgebung auf AWS für ein verbessertes Erlebnis

Das migrierte und modernisierte Moodle Infrastruktur bedeutet, dass The Open Die Universität kann nun folgende Vorteile nutzen Cloud-Vorteile.

Ein Einblick in eine einjährige RPA-Reise mit einem führenden digitalen Werbedienst

Ein Einblick in eine einjährige RPA-Reise mit einem führenden Anbieter von digitalen Werbedienstleistungen und -lösungen und wie NashTech ihnen geholfen hat.

Lassen Sie uns über Ihr Projekt sprechen

- Themen: